07.01.2026

Die Rückschau auf »Apple Intelligence« ist einfach. Denn es gibt nichts, auf das man zurückschauen könnte.

Trotzdem war es eines der aufregendsten Jahre der Computergeschichte. KI, abseits von Apple, ist förmlich explodiert. Viele Beobachter sprechen von einem »Inflection Point«, also von einem Zeitpunkt, ab dem sich die Dinge grundlegend verändern. Was bisher theoretisch diskutiert wurde, öffnete sich plötzlich als praktische Realität. Und zwar in einer Qualität, die selbst Optimisten verblüffte.

Relativ wenige Leute wissen davon. Das liegt daran, dass man KI weder in eine Kamera halten noch mit 100 Worten erklären kann. Zur Erinnerung: Vor der Smartphone-Ära war es die Aufgabe der Computerzeitschriften, zu erklären, wie die Dinge funktionierten. Aber durch das Smartphone wurde es möglich, einfach alles in die Kamera zu halten. Alles wurde visuell. Die Frage, wie etwas funktioniert, wandelte sich zur Frage, wo man tippen muss. Eine Weile war es nett, aber dann wurde es ein wenig öde.

Ich beobachte jedoch eine kleine Renaissance der verrückten Nerd-Szene, wie es sie zu Zeiten der ersten Home-Computer gab. Es wird wieder interessant, wie die Dinge funktionieren. Die Technik hat wieder ein Geheimnis, das es zu enträtseln gilt. Die neue Bewegung ist, wenn auch sehr klein, eine Art verrückter Cyberpunk, als wären die Leute gerade aus einem 8-Bit-Computerspiel gefallen. Es ist eine schräge Party mit lustig blinkenden GIFs, aber zum Glück ohne die grinsenden YouTube-Influencer, die einem mittlerweile auf den Sack gehen.

Ich werde nun – wohlwissend, dass es lange dauert, und wohlwissend, dass es kaum einen interessiert – die bahnbrechenden Ereignisse des Jahres 2025 zusammenfassen, erklären und einordnen.

Als Begründung, warum ich das tue, obwohl es fast niemand lesen wird, leihe ich mir die Begründung eines englischen Wissenschaftsjournalisten, der sagte:

»We think science is interesting. And if you don’t agree, you can fuck off.«

Der Trick

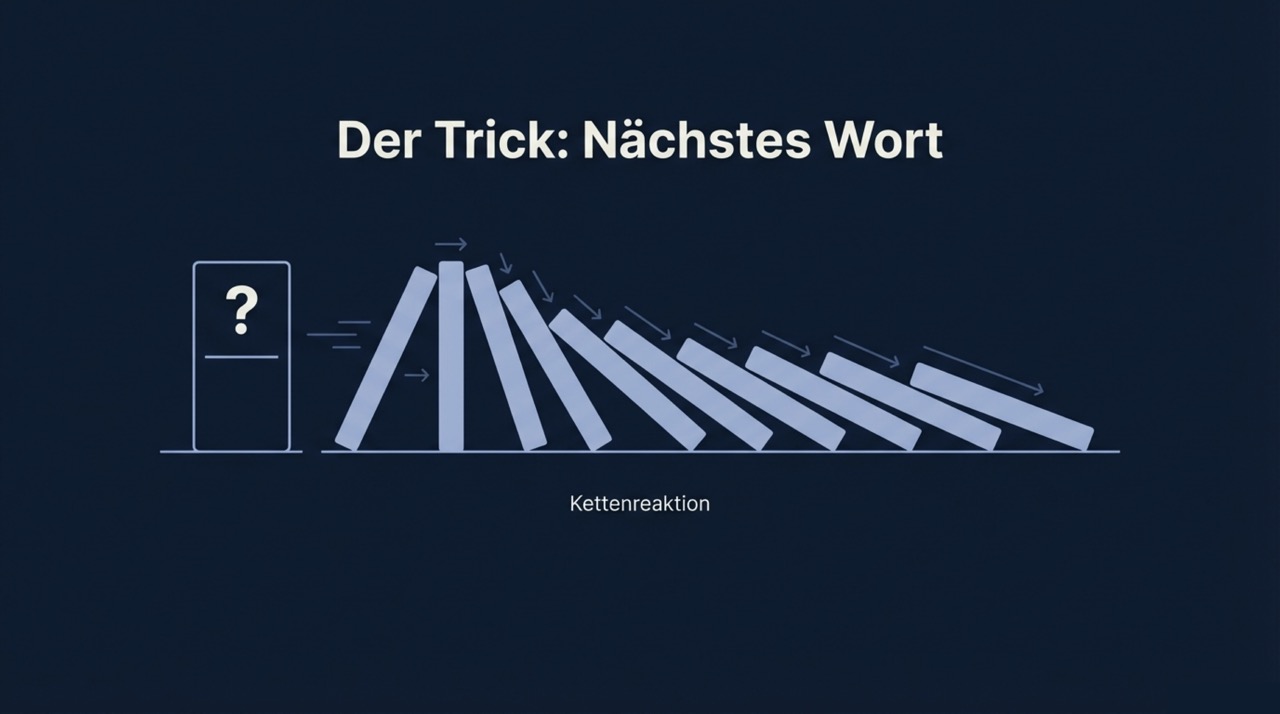

Wir starten mit einem kurzen Rückgriff. Im Jahr 2024 war die Welt noch in Ordnung. KI-Modelle (LLMs) beherrschten damals einen cleveren Trick: Sie konnten jeweils die nächste Silbe eines Satzes erraten. Dazu mussten sie wissen, welche Worte oft miteinander in Verbindungen stehen. Beispielsweise »Spinat« und »Ei«. Anhand von gigantischen Tabellen konnte man zu jeder Silbe berechnen, welche andere Silbe die höchste Wahrscheinlichkeit hatte. Auf »Sehr geehrter« folgt wahrscheinlich »Herr«. Auf »In Paris besuchten wir den« folgt wahrscheinlich »Eiffelturm«.

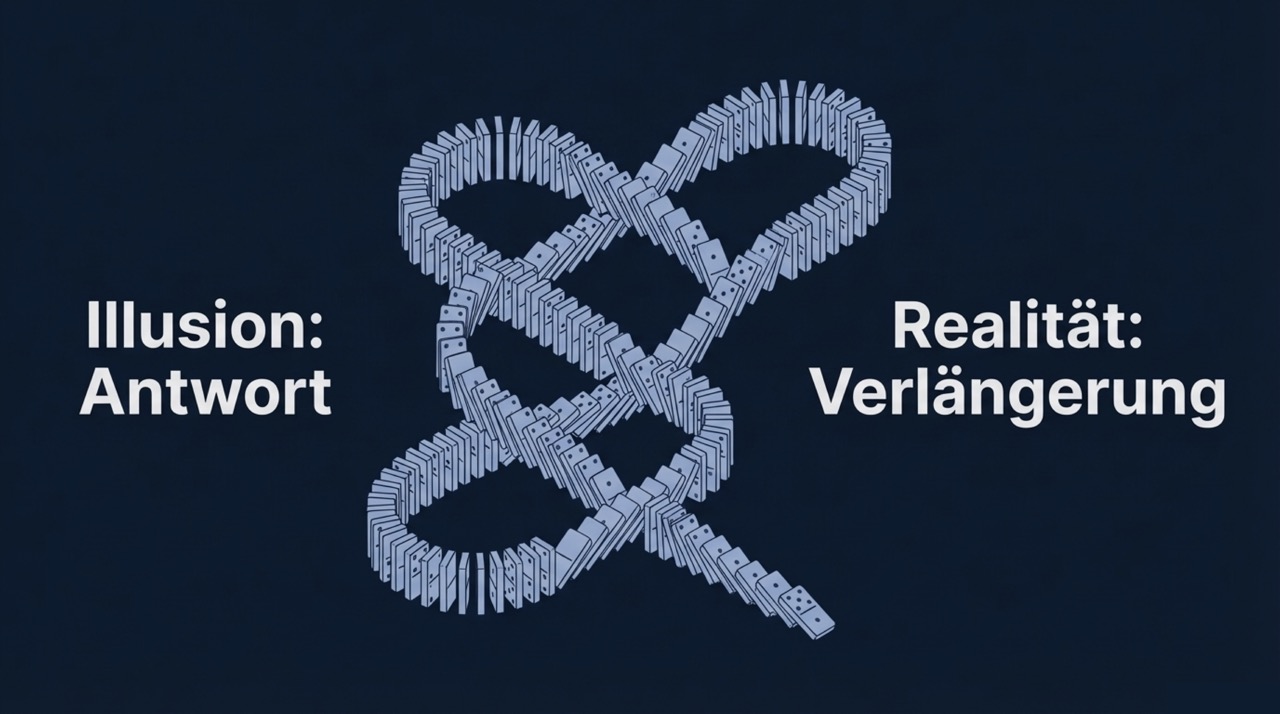

Verblüffend war damals, dass dieser Trick nicht nur von Silbe zu Silbe funktionierte. Sondern man konnte eine ellenlange Frage eintippen, und das System antwortete mit einer ellenlangen Antwort. Das verschleierte den Trick. Der Trick bestand nämlich nicht darin, eine Antwort zu berechnen; das war eine Illusion. Sondern der Trick bestand darin, die Frage zu verlängern. Das Modell überlegte, wie es nach der Frage normalerweise weitergehen würde.

Beispiel: Wer sagt: »Mir geht’s heute so schlecht«, erhält: »Ach, das tut mir aber leid«. Es funktioniert folgendermaßen: Das System spricht immer wieder den bekannten Text vor sich hin und fügt dann eine Silbe hinzu:

Mir geht es heute so schlecht.

Mir geht es heute so schlecht. Ach,

Mir geht es heute so schlecht. Ach, das

Mir geht es heute so schlecht. Ach, das tut

Mir geht es heute so schlecht. Ach, das tut mir

und so weiter.

Es ist eine Art »innerer Monolog«, bei dem das System vor sich hin murmelt. Wie lange macht es das? Das kann man beliebig einstellen, aber es wird irgendwann langsam und teuer. Warum? Weil jede zusätzliche Silbe nicht alleine berechnet wird (nur diese Silbe), sondern die KI muss immer den gesamten bisherigen Text aufsagen, anschließend hängt es eine einzige Silbe an. Irgendwann lohnt sich das nicht mehr.

Reasoning

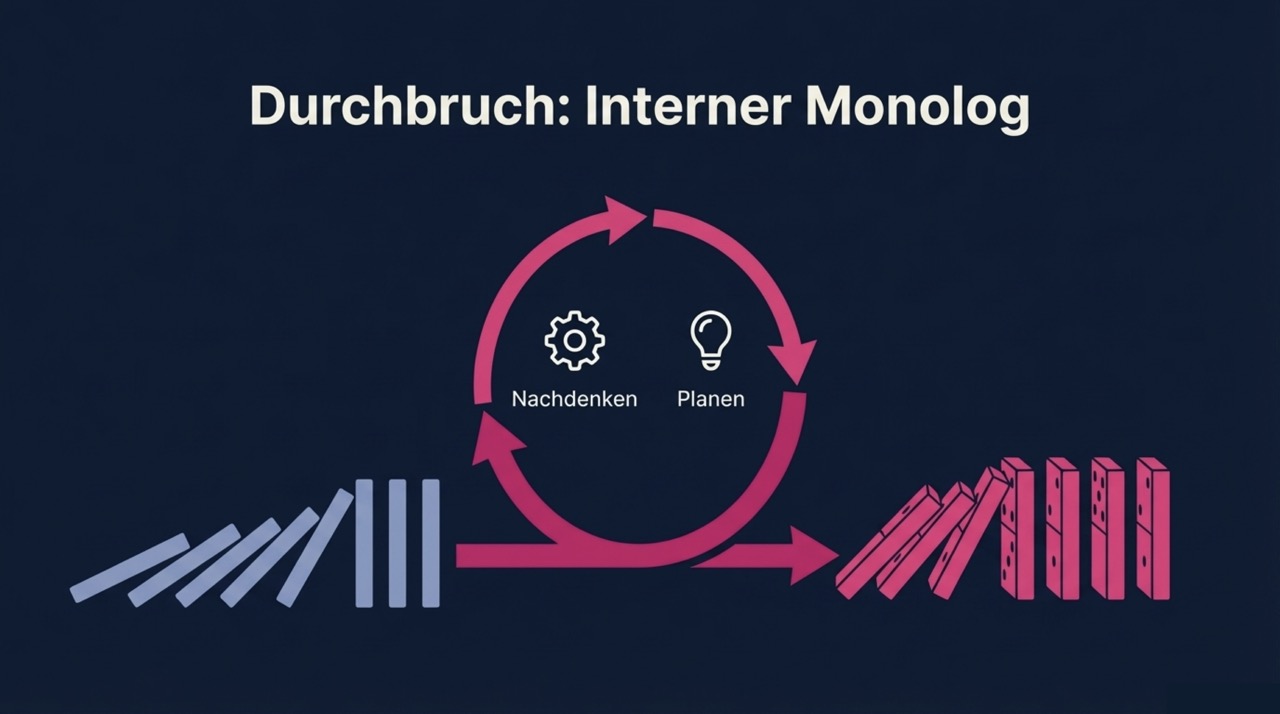

So ein System kann gute Antworten geben. Aber es ist nicht wirklich intelligent. Doch dann hat man entdeckt, dass man diesen »inneren Monolog« loslösen kann von der eigentlichen Antwort. Man verwendet den inneren Monolog, um vorher über die gestellte Aufgabe nachzudenken.

Auch das Nachdenken geschieht, verblüffenderweise, durch eine Aneinanderreihung der wahrscheinlichsten Silben. Mit dem Unterschied, dass man nicht mehr die gestellte Frage verlängert, sondern eine davon unabhängige Frage, die man zuerst lösen muss, um dann die Antwort geben zu können. Die Frage könnte lauten: »Um die Lösung zu finden, muss ich zuerst…«.

Nun könnte man darüber debattieren, ob die Maschine dadurch tatsächlich denkt. Letztlich reiht sie wieder nur Silben aneinander, die nach einem bestimmten Schema besonders wahrscheinlich sind.

Aber auch wir Menschen denken häufig nach, indem wir in einem inneren Monolog immer wieder die gleiche Sache durchkauen, bis wir die Antwort zu greifen bekommen. Wir denken immer wieder das Gleiche, jedes Mal einen Schritt weiter. Wir verlängern unsere Gedanken. Wir richten uns danach, welche Sachen gut zusammenpassen, und welche Dinge zu einem Konflikt führen: Wenn wir »Haus« denken, denken wir uns das Dach und die Fenster hinzu, weil diese Worte eine thematische Nähe haben. Hingegen ist das Wort »Kohlenstoff« weit weg. Sobald wir »Haus« denken, sortieren wir alle also anderen Begriffe danach, wie nah sie thematisch liegen. Wir ziehen nicht alle Begriffe in Betracht, sondern nur, was bei dieser Sortierung weit oben landete.

Dieser Zwischenschritt war eine umwälzende Entdeckung. Im Jahr 2024 veröffentlichte OpenAI das erste kommerzielle Modell, das auf diese Weise nachdenken konnte. Es trug den Namen o1.

Mehr Strom

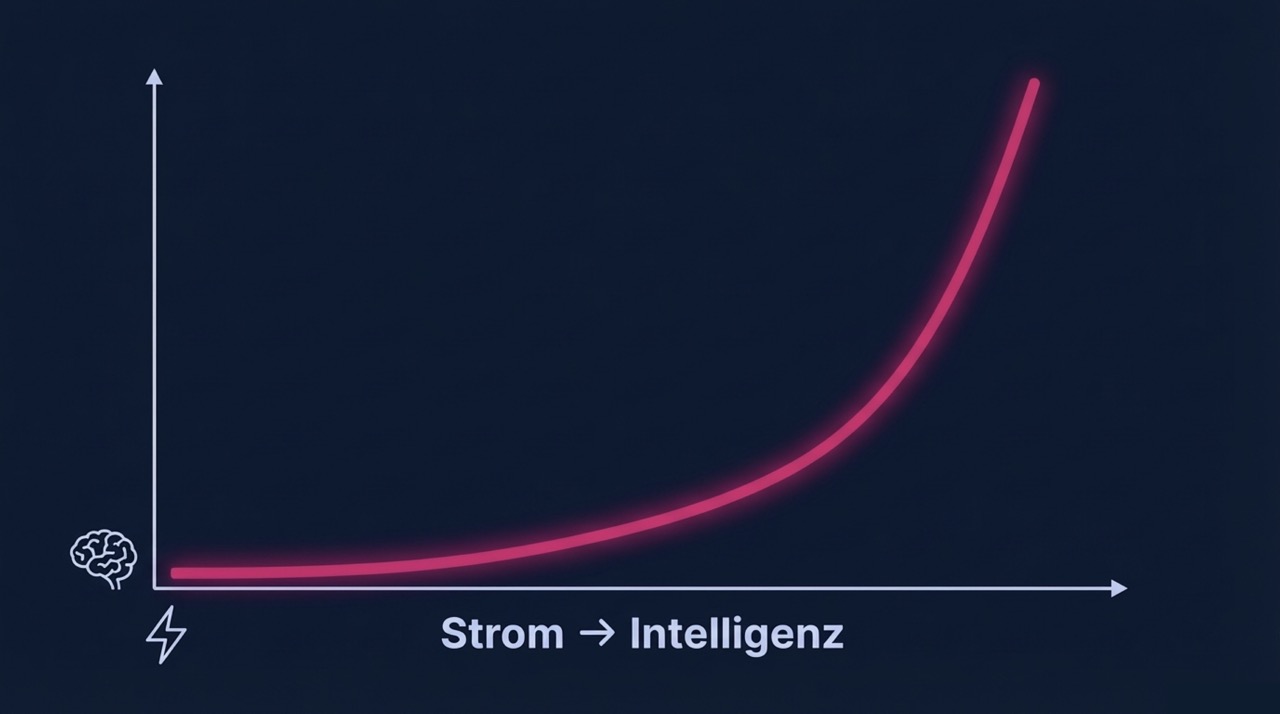

Eine weitere Erkenntnis schockte die KI-Szene kurz darauf: Je länger man ein Modell vor sich hin murmeln ließ, desto kniffligere Probleme konnte es lösen. Das ist nicht selbstverständlich. Zum Vergleich: Siri kann man nicht dadurch verbessern, dass man mehr Rechenkraft einsetzt. Excel wird nicht schlauer durch einen schnelleren Prozessor. In gleicher Weise ist ein Mac Pro ist nicht schlauer als ein Mac Mini, höchstens schneller. Aber bei KI ist das offenbar anders, sie wird schlauer.

Die Konsequenzen könnten sehr weitreichend sein. Was wäre, wenn ein Mac Pro tatsächlich schlauer wäre als ein Mac mini? Oder ein PC schlauer als ein Mac? Würde das nicht sehr viel ändern?

Eine weitere Beobachtung erscheint trivial, ist aber haarsträubend. Je mehr Silben das Modell für das Nachdenken verwendet, desto mehr Strom benötigt es. Die Öffentlichkeit ist (berechtigterweise!) besorgt darüber — so sehr, dass sie den weiteren Zusammenhang übersieht: Man kann Strom verwandeln in Intelligenz. Mehr Strom, mehr Intelligenz.

Das könnte eine der bahnbrechendsten Entdeckungen der Menschheit sein. Um Probleme zu lösen, benötigen wir Intelligenz; aber wir können Intelligenz nicht in beliebiger Menge erzeugen. Nun stellt sich heraus, dass wir Intelligenz aus Energie erzeugen können. Theoretisch in beliebiger Menge.

Gibt es eine Grenze?

Es wirft sofort die Frage auf: Ist die Menge wirklich beliebig? Niemand hat darauf eine abschließende Antwort. Aber es gibt ein paar Anhaltspunkte, die ich sehr aufregend finde.

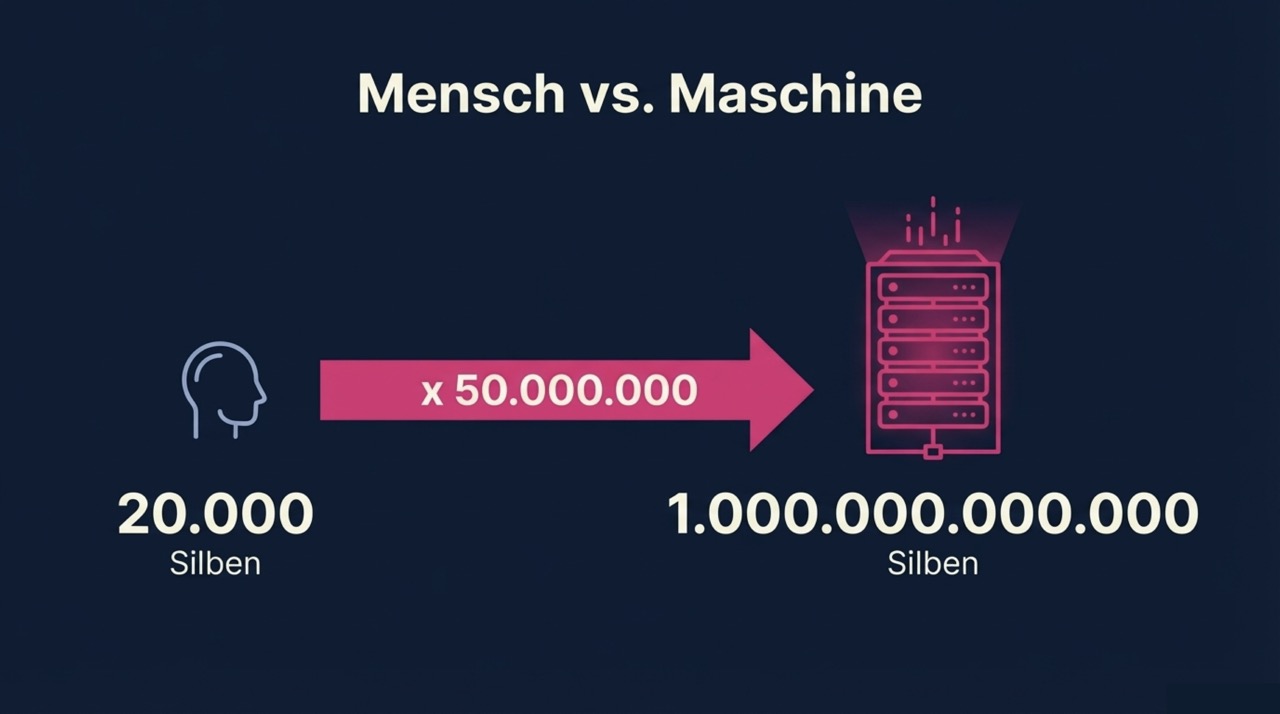

Zunächst: Beim Menschen ist die Menge der Intelligenz definitiv nicht beliebig, sondern eng begrenzt. Wenn ein Nobelpreisträger einen ganzen Arbeitstag vor sich hin denkt: Wie viel ist das? Es sind maximal 20.000 Silben. Es sind klügere Silben, als wenn sie von mir kämen. Aber ein KI-Modell in einem Rechenzentrum erreicht im gleichen Zeitraum Milliarden von Silben, demnächst womöglich eine Billion (tausend Milliarden). Das sind 1.000.000.000.000 Silben, unermüdlich, Tag und Nacht, auf Wunsch über Wochen und Monate.

Es ist schwierig, so große Zahlen zu ermessen, daher folgende Hilfestellung: Es ist fünfzig Millionen mal mehr. Anders gesagt: Es ist die Menge von fünfzig Millionen Nobelpreisträgern gleichzeitig. Plötzlich sehen die 20.000 Silben des Nobelpreisträgers nicht mehr ganz so eindrucksvoll aus.

Die Frage, ob eine KI irgendwann klüger werden könnte als ein Nobelpreisträger, erhält hier eine ganz andere Perspektive. Man sieht es sofort: Die Frage ist falsch gestellt. Der Nobelpreisträger mag zwar die klügsten 20.000 Silben der Weltgeschichte denken. Aber die KI denkt eine Billion. Wen kümmert es, ob ihre einzelnen Silben etwas dümmer sind?

Aber wo genau stehen wir heute? Es ist ja offensichtlich, dass wir derzeit nicht jedes Problem lösen können, indem wir einfach die Computer eine Weile rechnen lassen. Noch hat keine KI einen Nobelpreis erhalten.

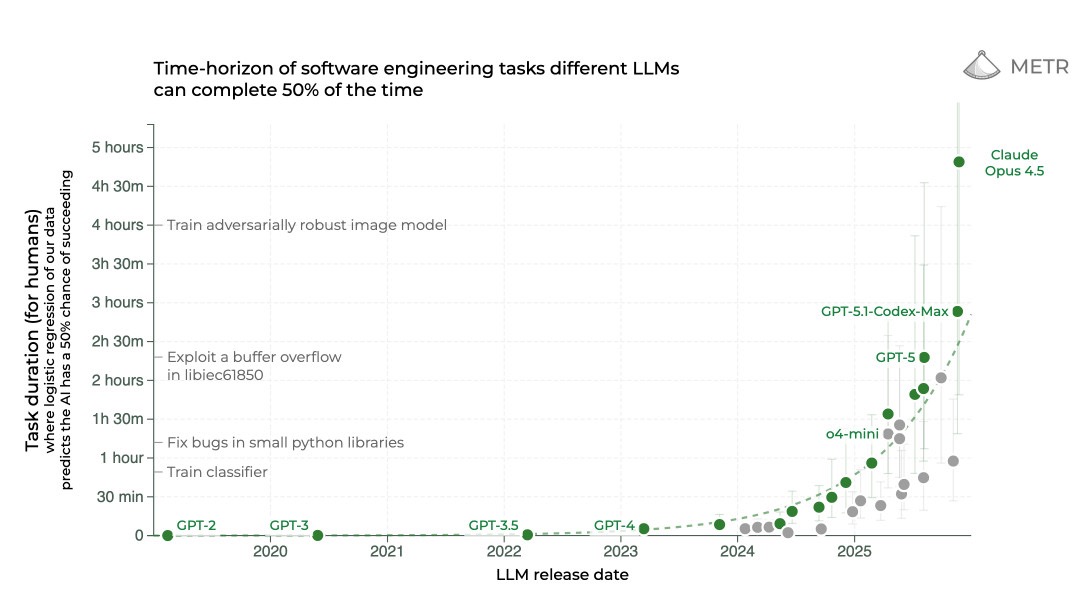

Die Grafik unten versucht es darzustellen. Es wird gemessen, wie lange eine Aufgabe sein darf (gemessen in menschlicher Arbeitszeit), sodass eine KI eine Erfolgsquote von 50% (oder besser) erreicht. Klingt kompliziert, bedeutet aber nur, dass man schaut, ob eine KI es schafft, eine Aufgabe zu lösen, für die ein Mensch eine Stunde lang arbeitet. Oder zwei Stunden, oder drei Stunden. Mit einer Erfolgsquote von 50% oder besser. Als Aufgaben wurden solche gewählt, die für die Software-Entwicklung typisch sind, etwa das Aufspüren eines Bugs.

Das ist wirklich interessant. Im Jahr 2022, mit GPT-3.5, gelang es nur bei Aufgaben, für die ein Mensch ein paar Minuten benötigte. Im Jahr 2024 stieg der Wert auf 15 bis 30 Minuten. Ende 2025, mit Opus 4.5, explodierte es auf 5 Stunden. Die KI kann also mit einer Erfolgsquote von 50% (oder besser) eine Aufgabe vollständig alleine lösen, für die Menschen fünf Stunden benötigen.

Das bedeutet: Ein Programmierer kann sich entweder fünf Stunden lang die Haare ausreißen, um einen versteckten Bug zu finden. Oder er übergibt es einer KI-Engine, mit einer Erfolgsquote von mindestens 50%.

Entscheidend ist: Die Kurve ist eindeutig exponentiell. Die Leistung verdoppelt sich alle 7 Monate. Ende des Jahres 2026 werden wir 10 oder 12 Stunden erreichen, also locker einen menschlichen Arbeitstag. Der Anstieg der Kurve ist dramatisch. Es deckt sich zudem mit anderen Benchmarks.

Wie kann das sein? Man hat doch überall von den Youtube-Influencern gehört, die großen Schritte wären vorbei und es ginge nur noch langsam vorwärts. Aber das Gegenteil trifft zu: Die Schritte werden größer, das Tempo zieht an. In den letzten zwei Monaten waren die Fortschritte größer als in den letzten zwei Jahren.

Der Zauberlehrling lernt zaubern

Um den nächsten Durchbruch zu verstehen, der von allen vermutlich der wichtigste ist, muss man sich kurz damit beschäftigen, wie es den Ingenieuren gelungen ist, den Modellen das Nachdenken beizubringen.

Denken ist zielgerichtet — aber trotzdem nicht strikt linear, nur nach vorwärts gewandt, eine Silbe nach der anderen. Sondern zum Denken gehört auch, dass man Hypothesen skizziert, ihre Tauglichkeit prüft, sie wieder verwirft und von vorne anfängt, bis man mit der Lösung zufrieden ist. Man denkt und bewertet das eigene Denken. Aber woher weiß eine Denkmaschine, dass sie richtig denkt?

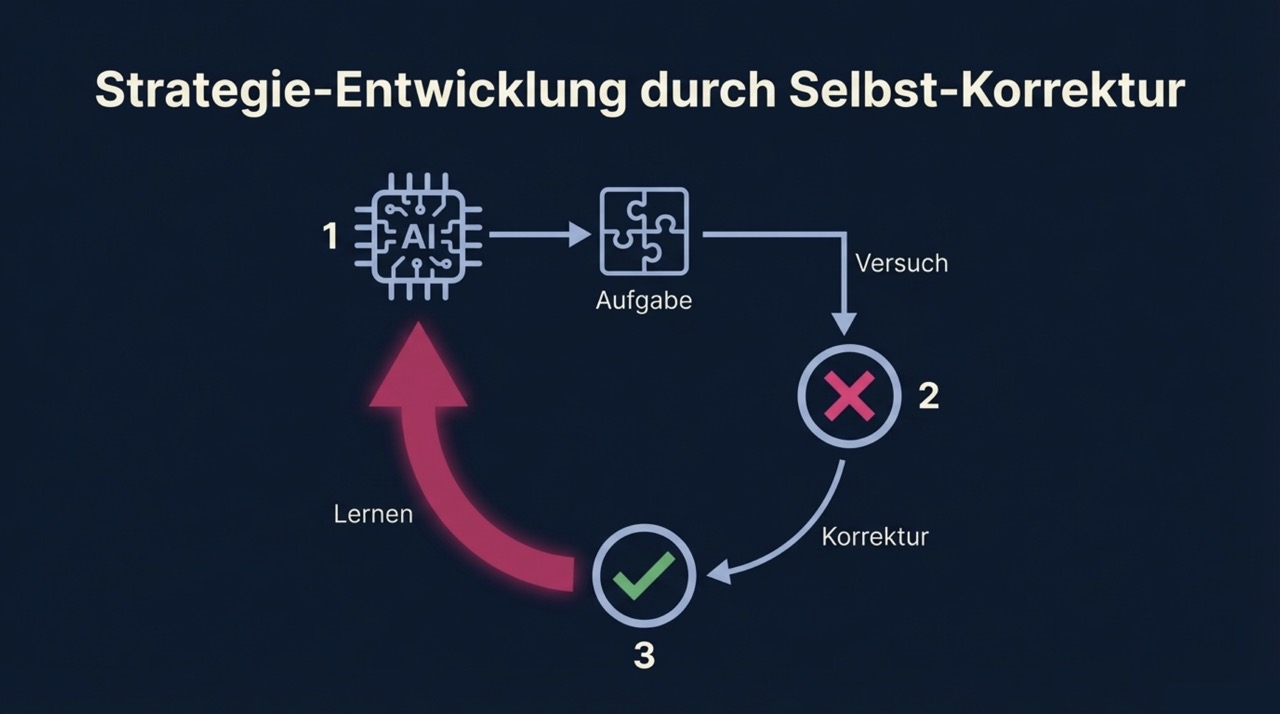

Die Ingenieure begannen, indem sie den Modellen Fragen stellten, die in Wahrheit kleine Rätsel waren, beispielsweise ein Puzzle oder eine Knobelaufgabe. Das Modell konnte also nicht einfach etwas daher plappern, Silbe auf Silbe.

Nach jedem Versuch zeigte man dem Modell die korrekte Antwort. Das Modell musste nun seine eigene Methode immer wieder verändern, bis es ebenfalls auf die Lösung kam. Dies geschah millionenfach. Weil es so oft wiederholt wurde, entstanden Muster, die das Modell auswerten konnte. Das Modell suchte in seinen eigenen Lösungswegen nach einem Muster, der typisch war für erfolgreiche Versuche.

Ein Muster konnte beispielsweise darin bestehen, eine Aufgabe in kleine Teilschritte zu teilen. Dadurch lernte es, was eine Strategie ist. Eine Strategie ist ein sinnvolles Planen, um ein vorgegebenes Ziel zu erreichen. Ist das Ergebnis fehlerhaft, wird der Plan an der betreffenden Stelle geändert und von dort erneut ausgeführt. Irgendwann, eventuell nach einigen fehlerhaften Zwischenschritten, gelangt das Modell zur korrekten Lösung.

Das Modell ist also nicht klug in dem Sinne, dass es alles weiß; sondern in dem Sinne, dass es mit strategischem Geschick so lange an der Aufgabe tüftelt, bis sie gelöst ist. Diese Fähigkeit zum strategischen Denken lässt sich trainieren.

Aus einer Plapper-Maschine wurde eine Strategie-Maschine.

Agenten

Diese Verbesserung führte im Februar 2025 zum nächsten Durchbruch. Als man dem Modell das strategische Denken beibrachte, griff man auf kleine Rätsel zurück, deren Lösung man kannte. Aber in der echten Welt kennt man die Lösung nicht — sonst bräuchte man ja keine KI, richtig?

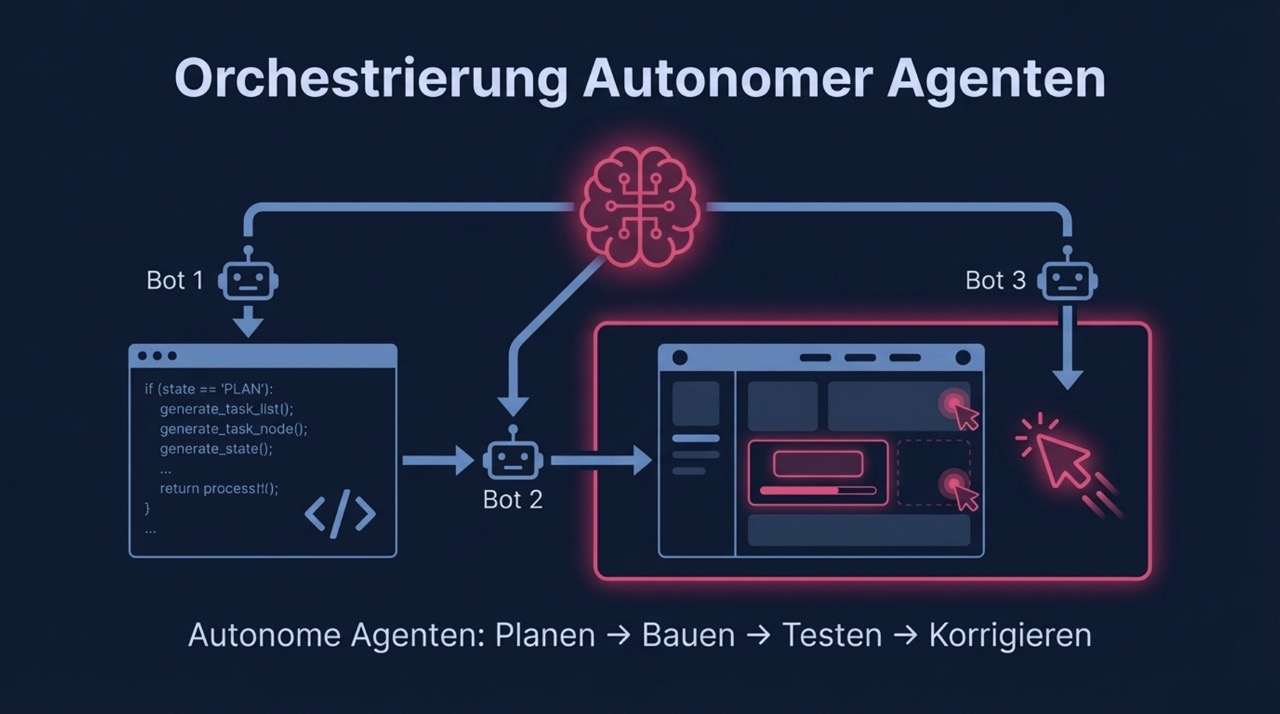

Falsch. Oft kennt man die Lösung. Nur weiß man nicht, wie man dahin gelangt. Wenn man die Lösung bereits kennt, dann lässt man das Modell so lange rechnen, bis es den Weg gefunden hat. Der entscheidende Punkt ist: Dadurch wird die KI autark. Sie weiß, wann sie am Ziel ist.

In welchen Fällen kennt man die Lösung? Beispielsweise bei Software. Wenn ein Mensch eine bestimmte Funktion programmiert, weiß er ja sehr exakt, was er damit erreichen möchte. Das teilt er dem Modell mit. Das Modell schreibt den Code, und (das ist der entscheidende Punkt) führt ihn aus. Dadurch kann das Modell prüfen, ob das Ergebnis dem entspricht, was der Mensch beauftragt hatte. Falls nicht, korrigiert das Modell den Code und probiert es erneut.

Man würde vielleicht annehmen, dass Programmcode, der von einem Computer selbst erzeugt wird, immer funktioniert. Das ist aber nicht der Fall. Die KI könnte an einer Stelle etwas ändern und dabei übersehen, dass es an anderer Stelle zu Problemen führt. Man merkt es erst, wenn man das Programm ausführt.

Diese Fähigkeit, Code selbst auszuführen, zu testen und zu korrigieren, gelang erstmals »Claude«, einem Modell der Firma Anthropic. Damals nahm kaum jemand Notiz davon (sicherlich nicht bei YouTube!), aber es war ein bedeutender Schritt nach vorne. Man kann recht sicher sein, dass wir im Jahr 2026 keine neue Software sehen werden, die nicht wenigstens teilweise auf diese Weise entstanden ist.

Gemini 3

Im November schlug Google zurück mit Gemini 3. Gemini umfasst zahlreiche Komponenten. Manche von ihnen sind für sich genommen Meilensteine, aber in der Öffentlichkeit wurde es gelangweilt bewertet als »das Gleiche wie vorher«. Tatsächlich stößt es in Bereiche vor, die nicht für möglich gehalten wurden; jedenfalls nicht so bald. Natürlich, wenn man einfach eingibt: »Rezept für Mohnkuchen«, dann wird man keine Differenz bemerken.

Gemini 3 kann komplette Programme (oder komplexe Funktionen darin) völlig eigenständig planen, programmieren, und testen. Das klingt in der Tat wie das, was ich bereits im vorigen Abschnitt beschrieben hatte. Aber der Unterschied liegt in der Komplexität der Aufgaben und in der Qualität der Ausführung. Die hohe Komplexität ist nur möglich, weil die Aufgabe zuvor sehr fachkundig geplant wird. Das war bisher noch die Aufgabe des Programmierers, auch wenn eine KI den Code schrieb. Jetzt plant die KI. Natürlich hat es eine gewisse Grenze. Aber es ist so gut, dass selbst erfahrene Programmierer sagen: Das war’s. Der Rest ist nur noch eine Frage der Zeit.

Ich habe mit eigenen Augen gesehen, auf meinem Desktop, wie Gemini eine neue Software plante. In Windeseile erzeugte die KI grobe Skizzen, verfeinerte sie, erkannte mögliche Probleme, notierte sie sorgfältig vorab zur späteren Beachtung — die Buchstaben flitzten nur so über den Bildschirm. Anschließend überprüfte sie, ob der Plan mit der gestellten Aufgabe exakt übereinstimmte.

Als das erreicht war, startete sofort die Programmierung. Kleine Bots gingen daran, den Plan Schritt für Schritt abzuarbeiten; wie Ameisen rannten sie über die Zeilen. Seitenweise entstand Code, noch mehr Code, neue Dateien, Ordner, wieder mehr Code. Ich konnte verfolgen, wie die einzelnen Aufgaben nacheinander mit kleinen Häkchen als erledigt markiert wurden, genau so, wie es ein Programmierer tun würde. Unaufhaltsam ging es voran.

Plötzlich startete das neue Programm. Ein Mauspfeil erschien, wie von Zauberhand geführt, klickte hier, klickte dort, testete alle Funktionen, atemlos, präzise, zielstrebig.

Dann schrieb die KI eine Anleitung für mich, wie die Software funktioniert, was ich vielleicht testen könnte und was die nächsten Schritte wären.

Es war fertig. Alles funktionierte.

Danach konnte ich für eine Stunde nur noch vor mich hin starren.

Die Arbeit von Tagen, vielleicht einer Woche: fertig in 10 Minuten. In einer Qualität und Sorgfalt, die ich mir selbst nicht immer gestatten kann. Ohne Zweifel ist es die größte Revolution bei Software jemals.

Nicht immer funktioniert alles auf Anhieb. Es braucht weiterhin den erfahrenen Programmierer, um auf Fehler hinzuweisen oder Dinge zu erkennen, die zwar technisch funktionieren, aber vielleicht nicht gut genug (oder viel zu kompliziert) sind. Aber die Geschwindigkeit, mit der das System auf solche Einwände reagiert und Lösungen dafür findet, ist so hoch, dass es insgesamt einen Programmierer zehnmal so produktiv sein lässt wie zuvor.

Ein paar Tage später lancierte OpenAI die neue Version 5.2 von ChatGPT, ebenfalls mit einem Programmier-Bot namens Codex. Die Fähigkeiten sind ähnlich spektakulär.

Dieses Prinzip – Planen, Ausführen, Prüfen, Korrigieren – lässt sich auf viele Branchen übertragen. Wo immer es klar definierte Prüfregeln gibt, wird die KI einbrechen. Sicherlich auch in anderen Bereichen, aber in diese auf jeden Fall.

Apple Intelligence

Werfen wir zum Schluss einen Blick auf das gesamte Szenario: In einem einzigen Jahr gelangen den großen KI-Anbietern gleich mehrere Durchbrüche. Es startete mit der Fähigkeit, über ein Problem nachzudenken. Dies führte zur Fähigkeit, Strategien zu entwickeln, um komplexe Probleme in kleine Schritte zu teilen. Bei prüfbaren Ergebnissen können die Modelle nun eigenständig erkennen, ob das Ergebnis erreicht wurde. Diese Fähigkeit alleine revolutioniert gerade die Software-Entwicklung.

Außerdem gelang Google im November ein enormer Schritt nach vorne bei der Erzeugung von Bildern und Videos. Die Ergebnisse sind von realen Aufnahmen kaum noch zu unterscheiden. In keinem Jahr zuvor war die Verbesserung so dramatisch. OpenAI bemüht sich, Schritt zu halten.

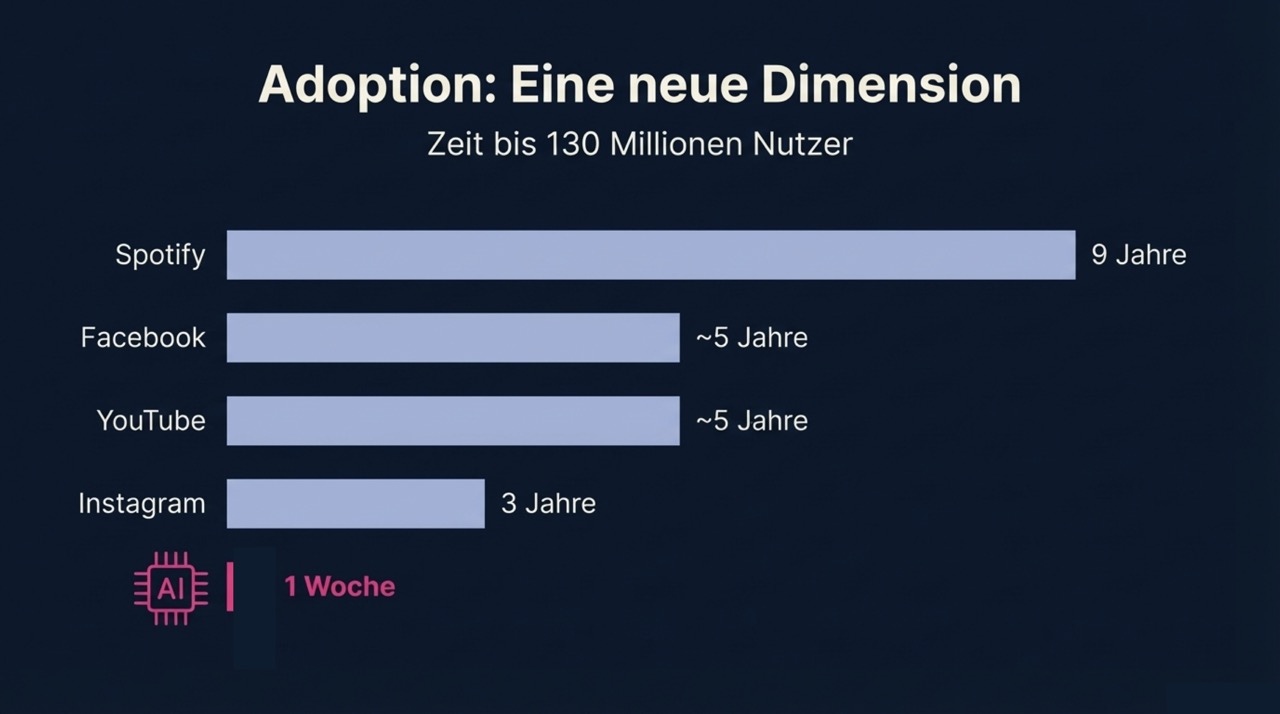

Das bleibt nicht unbemerkt: Kein anderer Dienst ist jemals so schnell gewachsen wie die Bilder-Engines von Google und OpenAI. OpenAI berichtet von 700 Millionen Bildern und 130 Millionen Nutzern in der ersten Woche nach Veröffentlichung der neuesten Version. Zum Vergleich: Facebook benötigte rund fünf Jahre, um 130 Millionen Nutzer zu erreichen. Bei Instagram waren es drei Jahre, YouTube fünf Jahre, Spotify neun Jahre. OpenAI: eine Woche.

Apple: Stille. Seit dem Jahr 2024, als »Apple Intelligence« verkündet wurde, gab es keine neuen Modelle. Auch die Integration der vorhandenen Fähigkeiten stagniert. Nach dem aufgekratzten Enthusiasmus scheint es nun so, als wollten Apples Entwickler möglichst wenig Aufmerksamkeit darauf lenken. Das ist wohl auch richtig so.

Es ist missverständlich wenn man sagt, Apple wäre soundso viele Jahre hintendran. Die Uhr tickt bei KI anders. Apple ist um Generationen hintendran. Selbst das ist noch geschönt, denn KI hat sich mittlerweile in einzelne Spezialgebiete aufgeteilt: allgemeine KI, Bilder/Video, Code-Generierung. Apple ist bei allen diesen Gebieten um Generationen hintendran. Genauer gesagt: Die letzten beiden fehlen bei Apple völlig, abgesehen vom peinlichen »Image Playground« (den Apple vom Markt nehmen sollte, weil er so furchtbar schlecht ist, dass es Apples Marke beschädigt).

2026

Man muss kein großer Prophet sein, um zu orakeln, dass das Jahr 2026 enorm große Fortschritte bringen wird. Manche Faktoren entwickeln sich exponentiell; manche Faktoren verhalten sich wie Schalter, die plötzlich einen Bereich zum Funktionieren bringen, der bisher unberührt blieb. Es wird überfallartig erscheinen, wenn man die kleineren Schritte zuvor nicht bemerkt hatte, die es ankündigten.

Software wird explodieren. Apps, die von einem einzigen Entwickler oder von kleinen Teams abhängen, erhalten Funktionen, die bisher außer Reichweite waren. Es wird auch viel unnützen Mist geben, denn die Verlockung ist einfach zu groß.

OpenAI wird versuchen, sich in Apps und auch in macOS zu integrieren. Ich bin gespannt, ob Apple dabei zusieht. Apple wird es nicht völlig verhindern können.

Bei Apple ist alles möglich. Vielleicht veröffentlicht man Fortschritte bei den eigenen Modellen; vielleicht wartet man damit lieber, bis sie konkurrenzfähig sind. Das kann noch Jahre dauern.

Angeblich hat man sich Gemini eingekauft, das ist eine gute Wahl. Es ist jedoch unsicher, was es bedeutet. Denn »Gemini« umfasst viele unterschiedliche Modelle, von winzig bis groß. Es ist möglich, dass es sich nur auf Siri bezieht.

Wenn wir Ende 2026 zurückblicken auf heute, wird es uns vorkommen wie die Steinzeit. Vieles wird wunderbar einfach sein. Natürlich werden wir alle arbeitslos, aber wir können das Formular fürs Sozialamt vollautomatisch ausfüllen lassen, auf Wunsch in vierzehn Sprachen.

Das ist natürlich nur ein Gag zum Schluss des Artikels, denn selbstverständlich werden auch die Leute vom Sozialamt rausgeschmissen.

Und die Leute, die die Leute vom Sozialamt rausgeschmissen haben, werden anschließend ebenfalls rausgeschmissen.

Das Schöne daran ist: Wir treffen uns alle im Apple-Store, wie damals in den 80ern, als wir Nerds jedem Samstag beim Kaufhof all die Ataris und Commodores angeschaut haben, für die wir kein Geld hatten.

So kommt alles zurück.

Außer das Geld natürlich.

PS: Alle Illustrationen bis auf das Titelbild stammen von Google Gemini. Ich habe der KI den ganzen langen Artikel zu lesen gegeben und die Aufgabe gestellt, dafür Illustrationen zu erstellen. Die Ergebnisse sind nicht perfekt, aber ich habe sie unverändert gelassen, damit man sehen kann, was sich mit einem einzigen kurzen Prompt erreichen lässt.

Diskussion im Forum

|